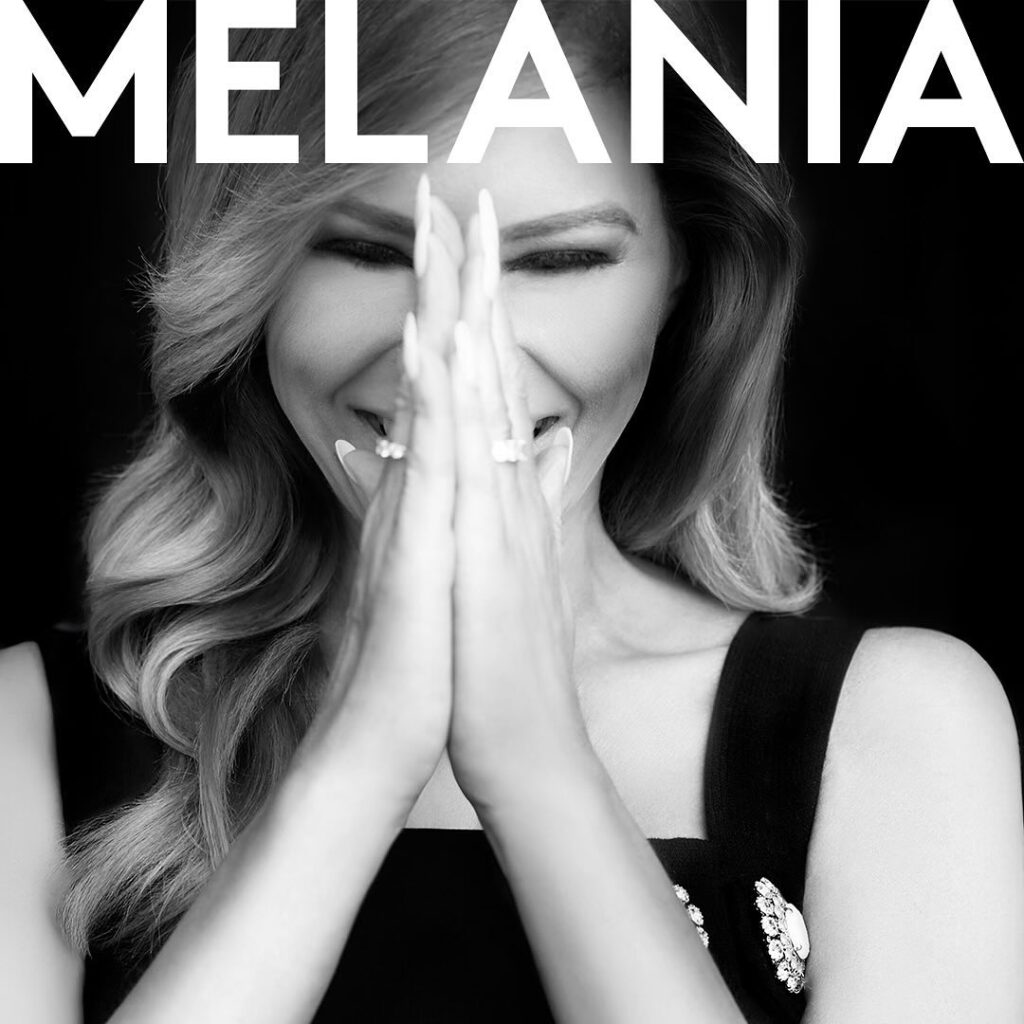

Τα deepfakes δεν έχουν τον θεό τους

Διαστρεβλώνουν την πραγματικότητα, δυσφημούν υπολήψεις, καταστρέφουν ζωές. Κι όμως, η λύση απέναντι στα deepfakes δεν είναι τεχνολογική.

Ακόμα κι αν αύριο το πρωί βρίσκαμε μια τεχνολογία που θα αναγνώριζε κατευθείαν τα deepfakes, η απειλή τους δε θα μπορούσε να εξαλειφθεί. Ο λόγος είναι πολύ απλός: Η τεχνολογία που είναι ικανή να βάλει ψέματα στο στόμα κάποιου, να μιμηθεί τη φωνή του ή ακόμα και τις εκφράσεις του προσώπου του δεν είναι ένα ζήτημα που μπορεί να λυθεί μόνο μέσα από τεχνολογικά αντίμετρα και αντίδοτα. Τα deepfakes έχουν προχωρήσουν τόσο ώστε να μην είναι αναγνωρίσιμα ακόμα κι από ένα έμπειρο ανθρώπινο μάτι.

Μέχρι σήμερα η μοναδική απάντηση που έχει δοθεί στο φαινόμενο των “πειραγμένων” βίντεο ήταν τεχνολογικής μορφής. Για παράδειγμα, το Facebook και η Microsoft επενδύουν σημαντικά ποσά στην έρευνα, ελπίζοντας να έχουν σύντομα στα χέρια τους κάποιο εργαλείο που να τα αναγνωρίζει με ηλεκτρονικό τρόπο. Σημαντικός σύμμαχος σε όλη αυτή την προσπάθεια είναι και η Google, που διαθέτει μια γιγάντια database από deepfakes, η οποία μπορεί να τροφοδοτεί το machine learning του μελλοντικού αυτού εργαλείου, ώστε να μπορεί να είναι πιο αποτελεσματικό.

Κι όμως, όλα αυτά δεν είναι αρκετά. Δεν υπάρχει καμία τεχνολογική πρωτοπορία ικανή να νικήσει τις διαφορετικές απειλές που ελλοχεύουν στο πρόβλημα με τα deepfakes. Ας θυμηθούμε την περίπτωση ενός βίντεο όπου η Αμερικανίδα πολιτικός των Δημοκρατικών Nancy Pelosi έμοιαζε μεθυσμένη. Παρότι στο τέλος το συγκεκριμένο κατέληξε στο μεγάλο κατάλογο των deepfakes, δε χρειαζόταν καμία προηγμένη τεχνολογία τεχνητής νοημοσύνης για να κάνει τη δουλειά. Αρκούσε κάποιος να επιβραδύνει ελάχιστα τη φωνή της με τέτοιον τρόπο ώστε να θυμίζει τη χαρακτηριστικά αργή ταχύτητα με την οποία μιλούν οι μεθυσμένοι.

Κανένα όμως ΑΙ λογισμικό δε θα μπορούσε να το αναγνωρίσει. Ακόμα όμως κι αν τα αυθεντικά deepfakes αφήνουν κάποιο ίχνος που τα αυτοματοποιημένα συστήματα θα μπορούν να εντοπίσουν, εγείρονται αμφιβολίες για την κρίση τους. “Όσο περισσότερο βασιζόμαστε σε αυτοματοποιημένα εργαλεία, τόσο πιο πιθανό είναι να έρθουμε αντιμέτωποι με ανακρίβειες και μορφές λογοκρισίας, που όμως δεν είναι σωστές” επεσήμανε η καθηγήτρια Kate Klonick σε δηλώσεις της στο MIT Tech Review. “Γιατί, τελικά, το να ορίσουμε τι είναι η σάτιρα, τι είναι τα deepfakes και τι είναι η μυθοπλασία είναι ένα πρόβλημα που άπτεται της φιλοσοφίας”.

Ως τέτοιο, λοιπόν, μπορεί να αντιμετωπιστεί μονάχα από το ανθρώπινο μυαλό, το οποίο είναι ικανό, για παράδειγμα, να ξεχωρίσει ότι ένα βίντεο που παρωδεί τη συμπεριφορά ενός σταρ του Χόλιγουντ είναι νόμιμο και καθόλου ηθικά μεμπτό, ενώ

ένα πορνογραφικό deepfake όπου πρωταγωνιστεί μια ηθοποιός του Χόλιγουντ χωρίς να το γνωρίζει, είναι κατάφωρη καταπάτηση των δικαιωμάτων της.

Έτσι, η μοναδική μέχρι στιγμής βιώσιμη λύση φαίνεται να είναι η μαζική χρήση ανθρώπων ή moderators, όπως είναι πιο γνωστοί στους διαδρόμους του ίντερνετ. Μόνο ένας εργαζόμενος μπορεί να αντιληφθεί τη λεπτή γραμμή που χωρίζει τη σάτιρα από τη συκοφαντική δυσφήμηση και να αντιληφθεί τον κοινωνικό και τον πολιτικό αντίκτυπο που μπορεί να έχει ή να μην έχει ένα βίντεο. Επίσης, είναι πολύ σημαντικό όσοι έχουν προσβληθεί από το φαινόμενο να μπορούν απλά και εύκολα να αναφέρουν το γεγονός, χωρίς να χρειάζεται να φτάσουν μέχρι τα βάθη των ρυθμίσεων του Instagram, του TikTok και των υπόλοιπων social media.

Όπως καταλαβαίνετε, η Nancy Pelosi διαθέτει τα εργαλεία για να πολεμήσει όλους όσοι χρησιμοποιούν τα deepfakes εις βάρος της. Τι θα συμβεί όμως με ένα παιδί που θα πέσει θύμα bullying στο σχολείο εξαιτίας κάποιου deepfake που έχουν κατασκευάσει οι συμμαθητές του; Επί της ουσίας, δε έχει κανέναν άλλο τρόπο για να παλέψει πέρα από τη δύναμη της φωνής του. Καλό, λοιπόν, θα ήταν να μπορούν να ελέγχουν οι ίδιες οι πλατφόρμες τέτοια φαινόμενα και να προχωρούν στην άμεση διαγραφή τους προτού τραυματιστεί ανεπανόρθωτα κάποια παιδική ψυχή.

Ακόμη όμως κι αν ο σκοπός είναι να δημιουργηθεί ένας ανιχνευτής deepfakes, εγείρονται παράλληλα πολλά ερωτήματα κοινωνικού τύπου. Θα είναι διαθέσιμος σε όλες τις χώρες; Θα είναι ικανός να αναγνωρίσει deepfakes σχετικά με την πολιτική ή ακόμα και με τη φυλετική ή τη σεξουαλική βία;

Κάπως έτσι, φτάνουμε στο επόμενο πρόβλημα: κάθε εργαλείο που πολεμά τα deepfakes, από τον ηλεκτρονικό ανιχνευτή μέχρι τους ανθρώπινους moderators, μπορεί να επέμβει εκ των υστέρων. Αν όμως θέλουμε να μειώσουμε ή και να εξαλείψουμε το φαινόμενο, θα πρέπει να μπορούμε να επέμβουμε από πριν. Άλλο ένα, δηλαδή, πρόβλημα που δεν μπορεί να λύσει η τεχνολογία, αλλά μόνο η δικαιοσύνη.

Από αυτή την οπτική γωνία, τα πράγματα δείχνουν τουλάχιστον κάπως πιο αισιόδοξα: Δύο ερευνήτριες, η Mary Anne Franks και η Danielle Citron, κατάφεραν να ορίσουν τον όρο “ψηφιακή πλαστογραφία” δίνοντας στους νομοθέτες ένα χρήσιμο πλαίσιο απέναντι στο πρόβλημα των deepfakes. Μέχρι σήμερα τα εν λόγω βίντεο έρχονταν αντιμέτωπα μόνο με κατηγορίες για δυσφήμηση. Στο άμεσο μέλλον όσοι κατασκευάζουν deepfakes, ακόμα κι αν δεν είναι δυσφημιστικά, μπορεί να έρθουν, τηρουμένων των αναλογιών, αντιμέτωποι και με το νόμο για πλαστογραφία.

Η δημοσίευση των deepfakes που είναι βλαβερή για τους ανθρώπους ή την κοινωνία θα πρέπει να θεωρείται έγκλημα. Φυσικά, αυτή η διαδρομή κρύβει κινδύνους πιθανής λογοκρισίας, όμως και η απόλυτη ανεξέλεγκτη “ελευθερία” καταντά επιβλαβής ελευθεριότητα.

Photo credit: η φωτογραφία του Πάπα Φραγκίσκου να φορά puffer jacket του οίκου Balenciaga είναι προϊόν ΑΙ. Creative Ανδρέας Κωστόπουλος

Πηνελόπη Παπανικολάου

Πηνελόπη Παπανικολάου

Εμμανουέλα Μαθιουδάκη

Εμμανουέλα Μαθιουδάκη